Um post de destaque da Flávia Crizanto, CEO da agência Experta Media, chamou a atenção para a importância do conceito de text embeding (embbed, embed, nós brasileiros fomos criativos na reinvenção) para respostas de IA. Digo “de destaque”, mas para mim. No material ela explicava o conceito relacionando-o ao mais recente modelo do Google EmbeddingGemma; curioso, resolvi explorar isso melhor.

Como escrevi em outro artigo, esses textos são parte do meu exercício de descobrimento de uma informação. Um exercício de organização para as ideias. Vem comigo entender o caminho que eu fiz.

Text Embeding: história de um conceito

A definição de embed é a primeira que eu queria visitar. No Oxford Dictionary ela aparece assim:

- Linguistics

- place (a phrase or clause) within another clause or sentence.”phrases or clauses that are embedded in a sentence for effect”

- incorporate (a video or other item of data) within the body of a web page or other document.”you can embed the videos into a blog post.”

Essas são algumas noções – as da linguística e as técnicas – que me fizeram destrambelhar um pouco quando me relacionei com o conceito de embed antes de ler o texto da Flávia. Já tinha visto referência a isso em outros materiais, mas nunca tinha entendido. No meu entender haviam dois entendimentos para o conceito:

Noção laica traduzida do inglês

Aqui eu estava pensando em como o “embed” era traduzido do inglês para o português – “embedar” era uma anglicização, então termos como “incorporar” faziam mais sentido. E “incorporar” pra fora do espiritismo eu consigo entender o que é. Não me parecia nada inovador.

Noção técnica do linguajar específico do desenvolvimento

Eu já tinha visto o termo aparecer em CMS’s quando queria incorporar (olha o uso latto do termo aqui) um tweet ou post do Instagram em um conteúdo. O “embed” tava lá.

Essas duas ideias me levaram a uma noção de que “embed” era, basicamente, achar um jeito de incorporar meus conteúdos em outros sites – uma estratégia mais rebuscada de link building usando por exemplo feeds RSS ou ferramentas similares (plugins, por exemplo). Mas foi a Flávia que me chamou a atenção para um campo que também usava o termo de maneira mais específica: a ciência da computação.

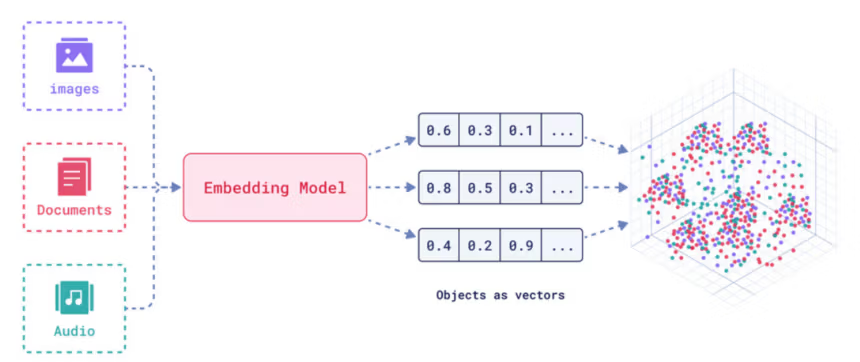

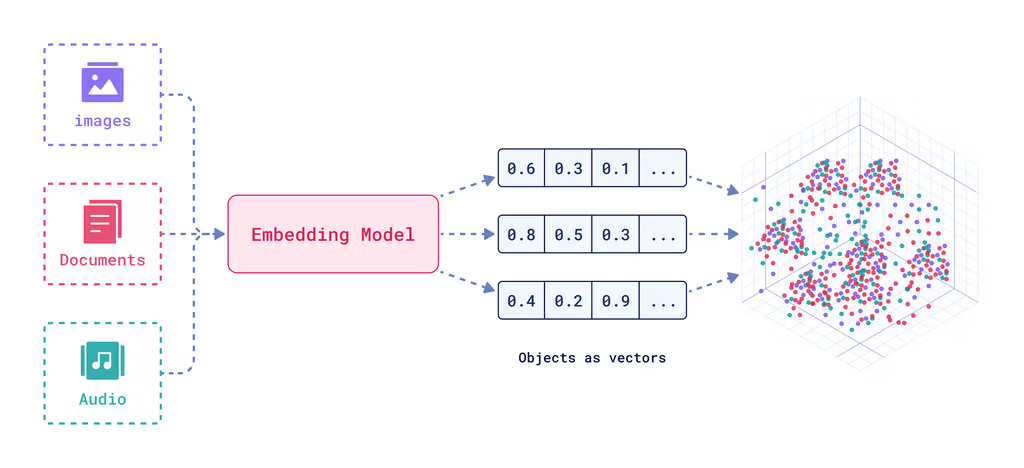

Vetorização e embeding

É curioso que eu estava acostumado com o conceito de embeding, mas sob outro nome: vetorização. Faz parte das aulas do Diogo Cortiz que assisti sobre IA, disponíveis no Youtube. A vetorização é uma distância vetorial entre dois polos, ou conceitos, e a inserção de um termo nesse vetor, pelo menos quando pensamos em vetorização no contexto de treinamento de LLMs transformers (modelos da família do GPT, por exemplo).

Para explicar ela, pense no rei Luís XIV. Esse nome próprio pode ter vários eixos, ou vetores: o eixo homem-mulher, no qual ele vai estar no extremo homem; o eixo plebeu-rei, no qual ele vai estar no valor rei; o eixo cruel-gentil… e aqui entra outro conceito. Ninguém é 100% cruel ou 100% gentil. Temos nossos momentos. Então eu colocaria ele perto do extremo de cruel, mas talvez não no extremo. Digamos, em 85% cruel. Aqui entra o fato de que entre quaisquer dois conceitos que formam um vetor (pontos em uma reta) temos uma escala que vai de 0 a 1. Ele seria um 0,85 cruel.

É isso que queremos dizer quando afirmamos que os vetores/embeds são divididos em bilhões de parâmetros (mais um termo para a salada). Eu só tinha lido essas coisas como vetores – talvez por familiaridade com a língua inglesa ou porque as referências que eu li não usavam embed. Mas buscando o conteúdo da Flávia, fui tendo contato com esse outro universo de autores que usam embed para se referir a esse processo.

Embed na prática

Talvez seja melhor explicar que embed não é a mesma coisa que vetorização. A vetorização que eu descrevi acima é algo mais amplo. O embed é, na prática, algo mais simples: a transformação de termos em códigos numéricos que representem todo esse processo de vetorização. Algo como – muito a grosso modo – se eu pegasse todos os bilhões de parâmetros do Luís XIV (branco-negro, loiro-moreno, olhos azuis-olhos castanhos, bom de cama-ruim de cama) e condensasse esses decimais em uma única “etiqueta” numérica.

Essa noção nos leva a dois contextos: o que a Flávia trouxe no seu post de uso dessa noção para conteúdos, e o EmbedGemma, que é outra coisa.

Embed textual e sua influência no trabalho do redator

Tem um jeito de pensar o embed textual na hora de escrever seus textos? A Flávia disse que isso funcionaria nessas linhas:

Um site não precisa ter a palavra exata usada na busca para ser considerado relevante. O Google consegue conectar sinônimos, contexto semântico e até intenções implícitas.

Isso faz sentido. Lembram quando disse que os vetores criam esses eixos? Imagine três vetores: rei-rainha, rei-plebeu, homem-mulher. No eixo “rei-rainha”, Luís XIV fica no extremo rei. Esse extremo “rei” tem outra direção: rei-plebeu, onde ele também fica como “rei”. Rei, rainha e plebeu começam a estar ligados pelo ponto “rei” (mas poderiam por quaisquer outros pontos dependendo de quantos parâmetros tenhamos).

Mas e o eixo homem-mulher? Um rei implica um homem, assim como uma rainha implica uma mulher. Essas implicações estão em outras vetorizações, como a da própria palavra mulher, que tem inclinação mais forte para “rainha” do que a palavra “homem”. Pelo menos, antigamente. Hoje todo mundo pode ser o que quiser.

É por meio dessas tecnologias que sinônimos, contextos semânticos e intenções implícitas aparecem algoritmicamente. E o embedding é a tradução disso em um número – o que agiliza e facilita a recuperação de informação.

Minhas críticas a essa noção

Eu sou bem cético quanto ao uso formal dessas lógicas de computação para a escrita. Quando alguém diz que usa “query fan-out” para escrever, ou modelo atômico disso e daquilo outro… dou dois passos para trás e tomo um copo d’água pra me acalmar.

O processo de criar a tecnologia do text vector embed é basicamente ser capaz de compreender o que já existe em termos de texto – a forma como as pessoas já se expressam via palavras – e algoritmizar isso. Veja bem, é a ciência da computação quem corre atrás de criar um uma tecnologia que consiga explicar e entender o que nós, humanos, fazemos com a cabeça desde sempre: identificar, entender e curtir um bom texto.

A noção de text embed precisa ser internalizada por um redator? Talvez sim. Mas não porque ela vai ajudar o redator a escrever melhor. O caminho é reverso: escrever bem é que vai fazer o redator alguém entendível por um sistema que usa text embed.

Percebe como a lógica é reversa? Digamos que eu queira entender as relações dos personagens da Biblia, ou de Senhor dos Anéis, ou da Ilíada. Eu vou usar um text vector embed para calcular as distâncias entre Páris e Aquiles, entre Frodo e Sam, e entre Matheus e Jesus, por exemplo. Eu não preciso reescrever a Bíblia para tornar clara a relação entre esses personagens. Foi o encanto pela forma como a obra foi construída que nos faz dedicar tempo para desenvolver tecnologias que nos ajudem a indexar, organizar e trabalhar melhor esses textos.

Mas vou fazer uma defesa da minha colega. Ela contrapõe claramente que isso significaria que o redator não precisa mais se preocupar com a repetição de palavras-chave secundárias – algo bem em linha com a abordagem semântica que o Alexander Rodrigues sempre prega no seu SEO Semântico. Nesse ponto ela está coberta de razão. Só que isso não tem nada a ver com o EmbedGemma.

Onde o EmbeddingGemma entra na história?

O Google sempre pega os SEOs de surpresa. Seja com uma patente, com uma publicação no X, com um post em seu blog ou com uma declaração em um evento. A gente tenta – e é parte da graça de ser um profissional de SEO – ler as entrelinhas e quebrar o código na nossa cabeça. O EmbeddingGemma pode acabar nos distraindo por isso.

Esse sistema não diz nada acerca de como o algoritmo do Google trabalha (embora eu aposte umas fichas que o algoritmo do Google usa parte disso, sim). A ideia desse modelo é que ele seria uma tecnologia capaz de fazer o processo de embedar rodar em máquinas locais. É parte de algo que sempre compôs o modelo de negócios do Google, ser meio opensource ou liberar alguns meio-brinquedos pra comunidade dev experimentar e criar.

Olha como eles se referem no primeiro parágrafo do artigo que apresenta a tecnologia:

Designed specifically for on-device AI, its highly efficient 308 million parameter design enables you to build applications using techniques such as Retrieval Augmented Generation (RAG) and semantic search that run directly on your hardware. It delivers private, high-quality embeddings that work anywhere, even without an internet connection.

Desenhado especificamente para IA local, seu design de alta eficiência de 308 milhões de parâmetros te permite construir aplicações usando técnicas de Retrieval Augmented Generation (RAG) e busca semântica rodando direto no seu hardware. Ele entrega embeddings privados de alta qualidade que funcionam em qualquer lugar, mesmo sem conexão com a internet (tradução minha).

Percebem como a chamada é publicitária? Instiga o download e a implementação. Flerta com as vantagens para o desenvolvimento de soluções locais.

O EmbeddingGemma não é mais uma peça do quebra-cabeças do algoritmo do Google. O que ele nos permite é refletir: será que algo parecido não rola nos índices do Google? Qual a possibilidade do Google já ter algo nessas linhas sendo implementado em algum ponto? Qual o interesse do Google em difundir essa tecnologia?

O que eu levo disso para os textos

Pensando em como escrever um texto, o que eu acho que funciona na prática, em uma listinha pra você consultar:

- Use conectivos no texto. Isso ajuda, dada a sua natureza, a qualquer ferramenta entender a ligação entre dois conceitos.

- Mapeie e use termos específicos do nicho. Sempre ouvimos que tornar o texto simples era bom, mas acho que parte do tônus está em citar um termo muito particular, que vai aumentar sua inserção em uma rede semântica de um domínio do conhecimento.

- Termos compostos são bons. Viram que eu usei “domínio do conhecimento” no ponto 2? É um termo da Ciência da Informação. É melhor do que usar só “domínio”, que é amplo, e pode ir do “domínio de bola” até o “domínio do mundo”.

- Apesar do que dizem, alguma repetição da palavra-chave principal ainda importa. Eu sou fã da semântica, mas não acredito que todos os sistemas dos buscadores que usam palavra-chave para se orientar foram desativados. Eles ainda influenciam em parte o trabalho.

- Continue escrevendo bem. Tem alguma coisa – que até agora ninguém soube explicar direito – de comum em um bom texto. Continue procurando ela, que ele tende a ser recompensado.

Pra você não se perder

Separei aqui com a ajuda do ChatGPT uma tabela dos termos técnicos e sua relação sempre que você achar que fui “técnico demais”:

| Conceito | Definição |

|---|---|

| Flávia Crizanto | CEO da agência Experta Media; autora de um post que destacou a importância do conceito de text embedding aplicado a respostas de IA. |

| Experta Media | Agência de comunicação e marketing digital dirigida por Flávia Crizanto. |

| Text Embedding (ou Embeding/Embed) | Técnica da ciência da computação e de IA que transforma palavras, frases ou documentos em vetores numéricos, preservando relações semânticas entre termos. |

| Google EmbeddingGemma | Modelo lançado pelo Google para criar embeddings localmente em dispositivos, com foco em eficiência e uso em aplicações de busca semântica e Retrieval Augmented Generation (RAG). |

| CMS (Content Management System) | Sistema de gerenciamento de conteúdo usado para criar e administrar sites, no qual o termo embed aparece como recurso para incorporar conteúdos externos (tweets, vídeos, etc.). |

| Vetorização | Processo matemático de representar conceitos em vetores numéricos multidimensionais; utilizado em modelos de linguagem para medir proximidade semântica entre palavras. |

| Diogo Cortiz | Pesquisador e professor brasileiro, especialista em IA e autor de cursos sobre o tema no YouTube. |

| LLM (Large Language Model) | Modelos de linguagem de grande porte, como GPT, que usam embeddings e vetorização para processar e gerar linguagem natural. |

| Transformers | Arquitetura de redes neurais usada em LLMs, baseada em mecanismos de atenção, fundamental para processamento de linguagem natural. |

| Qdrant | Banco de dados especializado em vetores, usado para armazenar e consultar embeddings de maneira eficiente. |

| Query Fan-out | Estratégia de busca em sistemas de informação em que uma consulta inicial é expandida em várias consultas derivadas para recuperar resultados mais amplos. |

| SEO Semântico | Abordagem do SEO (Search Engine Optimization) defendida por Alexander Rodrigues, que valoriza contexto semântico, sinônimos e intenção de busca além do uso repetitivo de palavras-chave. |

| Alexander Rodrigues | Especialista em SEO mencionado no texto por sua defesa da abordagem semântica na otimização de conteúdos. |

| Retrieval Augmented Generation (RAG) | Técnica de IA que combina geração de linguagem com busca em bases externas, aumentando a precisão e relevância das respostas. |

| Domínio do conhecimento | Conceito da Ciência da Informação que representa um campo específico de saber, delimitado por termos, conceitos e relações próprias. |

| Parâmetros | Valores numéricos ajustados em modelos de IA (como LLMs) que determinam como as informações são processadas e representadas, podendo chegar a bilhões em modelos avançados. |

Referências:

https://arxiv.org/html/2406.01607v2

https://link.springer.com/chapter/10.1007/978-3-030-88389-8_16

Victor Gabry é colunista de Não é Agência. Isso significa que ele é responsável pelos processos de redação. Além disso, o conteúdo não reflete, necessariamente, a visão da portal

Mestrando em Ciência da Informação com tema de pesquisa Domínio do SEO e Regimes de Informação, com mais de 5 anos de experiência prática na área, procuro transformar o complexo em fácil sem fazer parecer simples.

- Victor Gabryhttps://naoeagencia.com.br/author/victorgabry/