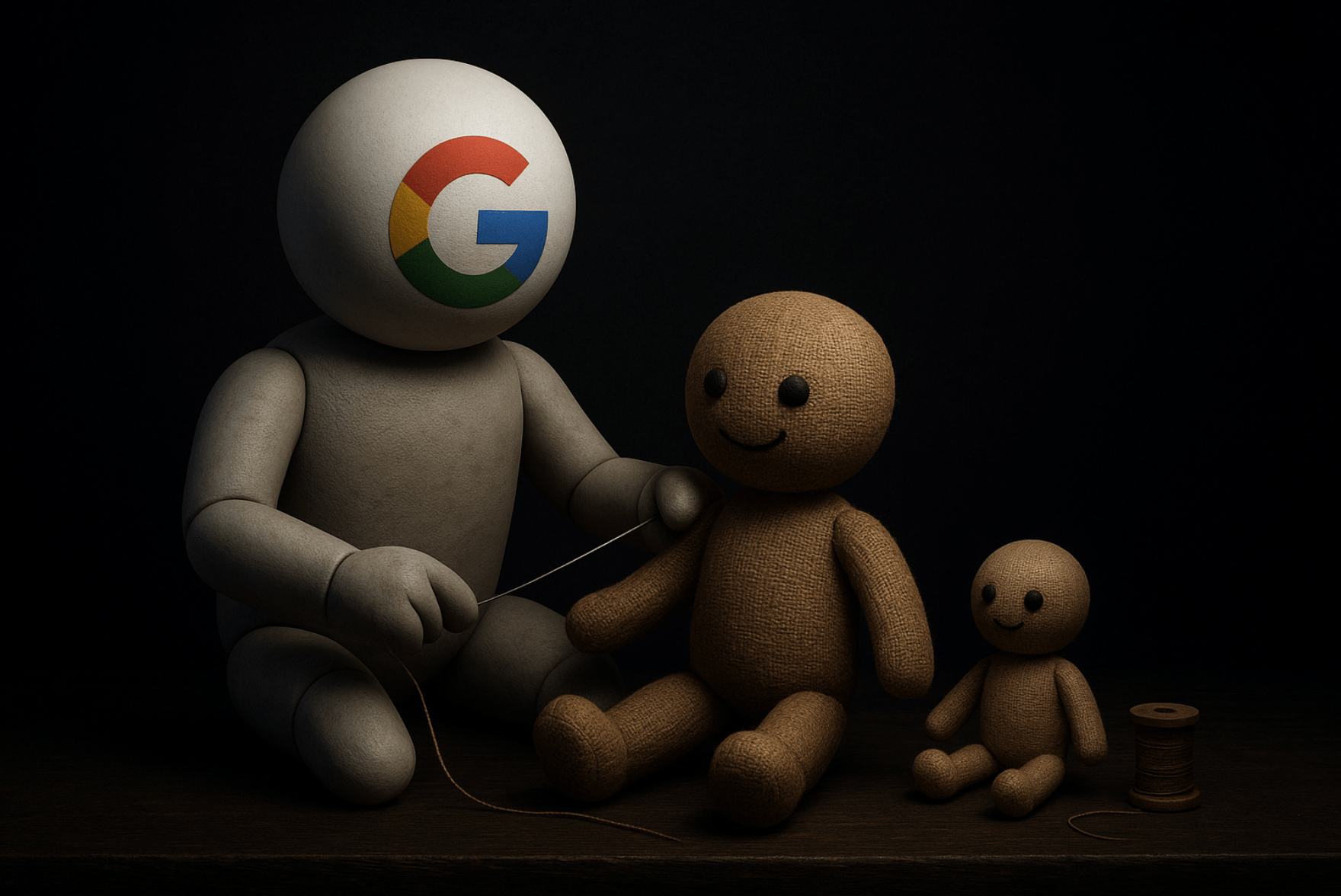

A internet que conhecíamos, rica em diversidade e profundidade, parece estar se esvaindo. Muitos apontam para um culpado central nessa transformação: o Google. O gigante das buscas, que um dia foi sinônimo de acesso à informação de qualidade, hoje é frequentemente associado à erosão do próprio ecossistema que ajudou a construir. Mas como chegamos a esse ponto?

Agradeço, aqui, a SEObook por muitos dos contextos utilizados neste conteúdo.

- Da curadoria à monetização agressiva: uma mudança de rumo

- Departamento de Justiça e o acúmulo de poder

- O jogo de gato e rato: sinais de qualidade vs. otimizações vazias

- O desalinhamento fatal: Google vs. publishers

- Atualizações do Google: quem são os prejudicados?

- O futuro do contéudo

- A tempestade perfeita: de blogs a feeds, de jornais a private equity, e agora… IA

- O que faz alguém produzir conteúdo hoje?

- Conteúdo útil?

- O histórico de práticas questionáveis e o futuro incerto

- Uma encruzilhada para a qualidade da web

Da curadoria à monetização agressiva: uma mudança de rumo

Houve um tempo, personificado por figuras como Matt Cutts no Google, em que a empresa parecia genuinamente empenhada em equilibrar os interesses, promovendo um “jogo limpo”. As primeiras campanhas contra práticas duvidosas, mesmo que às vezes beirassem o alarmismo (como associar a venda de links a falsas curas para o câncer), demonstravam um esforço para manter a qualidade dos resultados orgânicos.

No entanto, essa balança começou a pender.

- Anúncios disfarçados: Os anúncios, inicialmente bem sinalizados, tornaram-se progressivamente menos distintos do conteúdo orgânico.

- Densidade de anúncios: A quantidade de espaço dedicado a resultados pagos aumentou consideravelmente.

Essas não foram evoluções naturais, mas uma “série de decisões”, como aponta a análise inicial: “O que medir, o que otimizar, o que subsidiar, e o que sacrificar”. O foco mudou gradualmente para elementos que impulsionavam o crescimento das ações, muitas vezes em detrimento da experiência do usuário e da saúde do ecossistema de conteúdo.

Departamento de Justiça e o acúmulo de poder

O Departamento de Justiça tem analisado há muitos anos a concentração de poder existente pelo Google. Mesmo muitos dos mais liberais conseguem ver que a linha entre as ações benéficas da empresa e as maléficas foi cruzada.

A cada ano, o Google se apropriava de mais itens e empresas. Em todos os casos, mais editores se saiam prejudicados. Como veremos abaixo, hoje, o Google depende muito pouco dos editores para ter receita.

Tudo em nome de uma pretensa Experiência do Usuário. Obviamente, aqui, a experiência é um tanto quanto melhor quando não são necessários os intermediários, mesmo que eles sejam justamente quem me permitiu entender a dinâmica de cada busca.

No final do dia, o Google com seus bilhões de dados e sinais está em uma posição muito privilegiada. Ele consegue entender como cada empresa ganha dinheiro, e se calhar, ele implementa a feature dentro do buscador.

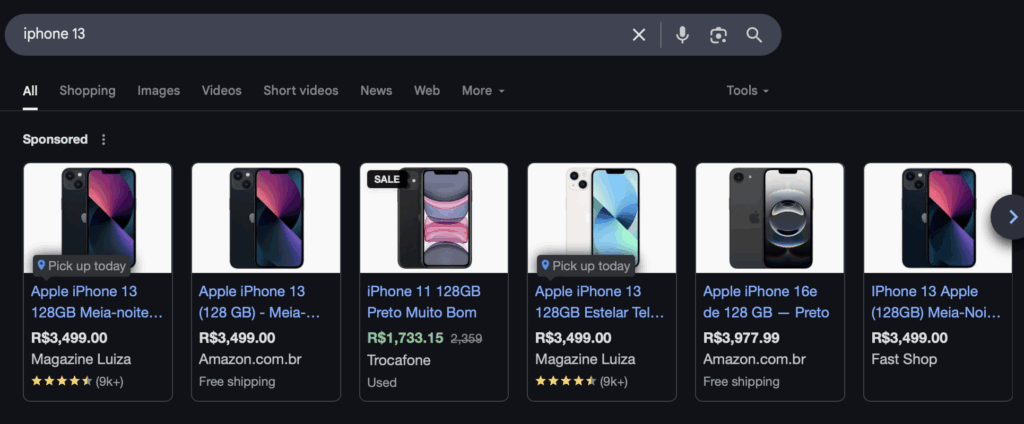

Ao ver que agregadores de preços conseguiam faturar com grandes informações de preços, o Google revoluciona mais uma vez a Internet trazendo grande parte disso no Google Shopping.

No final das contas, boa parte dos negócios existentes no digital vive até serem encontrados pelo Google. Viver abaixo do radar é importante.

Para jogar a pá de cal, temos a Inteligência Artificial Generativa. Ao responder, muitas vezes errado, ás perguntas, os cliques para os sites dos profissionais que bem responderam é quase erradicado.

O jogo de gato e rato: sinais de qualidade vs. otimizações vazias

Editores experientes aprenderam a “surfar” nos sinais que o Google valorizava: repetição de palavras-chave, links, texto âncora focado, domínios com palavras-chave. Novas ondas tecnológicas, como blogs e mídias sociais, foram aproveitadas. Contudo, o que era um sinal de qualidade ontem, podia se tornar uma anomalia amanhã, penalizando sites que antes beneficiava.

Cabe ressaltar que, embora o Google valorizasse tais sinais, sempre fez questão de mostrar sua oposição a eles. Isso mostra um fenômeno que vemos até hoje: defender publicamente o jornalismo, os pequenos editores e qualidade do conteúdo enquanto distribui conteúdos que vão, justamente, na contramão disso tudo.

Com o crescimento orgânico se tornando mais difícil, a influência dos “caras do dinheiro” sobrepujou o talento técnico. Um exemplo crítico ocorreu em 2019, quando, segundo o Googler Ben Gnomes, a equipe de anúncios incentivou as equipes de busca orgânica e do Chrome a degradarem intencionalmente a experiência do usuário para aumentar o volume de buscas:

“Acho bom aspirarmos ao crescimento de consultas e a mais usuários. Mas acho que estamos nos envolvendo demais com anúncios para o bem do produto e da empresa.“

Um ecossistema saudável depende de seus atores centrais operarem de forma transparente. Quando decidem “comer o bolo inteiro”, como metaforizado, o sistema desmorona. Otimizações de curto prazo pavimentam o caminho para falhas de longo prazo. A especificidade de um artigo do eHow, por exemplo, garantia uma boa pontuação de Relevância da Informação (IR), e o AdSense financiava a criação de milhares de artigos similares, resultando em uma “mesmice superficial” que, por sua vez, exigia a criação de novos sinais de ranqueamento.

O desalinhamento fatal: Google vs. publishers

O desalinhamento entre os interesses do Google e os dos produtores de conteúdo nunca foi tão gritante. No primeiro trimestre de 2025, pela primeira vez na história da empresa, a rede de parceiros do Google representou menos de 10% das receitas de publicidade. Esse ecossistema de parceiros, composto por centenas de milhares de publishers e milhões de empregos, está sob imensa pressão.

Publishers investem em conteúdo de qualidade, que é caro, e tentam subsidiar esse trabalho com formatos mais baratos e lucrativos. O tráfego de busca que recebem hoje para certas páginas pode parecer uma estratégia vencedora, mas as constantes mudanças nos sinais de ranqueamento espremem os lucros dessas “otimizações”, podendo levar a penalizações futuras em todo o site.

Nesse sentido, muitas vezes, grandes empresas se veem na necessidade de procurar formas distintas para conseguir tráfego. Algumas delas de qualidade muito duvidável.

Entretanto, dificilmente essas empresas optariam por tais decisões caso o próprio Google tomasse a dianteira na qualidade do conteúdo.

Nos exemplos que analisamos, parte relevante do tráfego de Discover era entregue para conteúdos que agregavam pouco ou nada aos usuários, enquanto esses mesmos portais tinham notícias de nível muito melhor.

Isso significa que o próprio Google condiciona a Internet que temos hoje. Ele dita, dia após dia, o que terá e o que não terá sucesso.

Este portal, por exemplo, tem pouco ou nenhuma ambição de ser encontrado em massa por vias orgânicas. Essa decisão se baseia justamente em não querer se submeter ao conteúdo que “dá certo”, em vez de seguir todos os princípios que fizeram com que ele fosse criado.

Atualizações do Google: quem são os prejudicados?

No X, a comunidade tem se tornado mais crítica. Embora o Google tente fazer eventos para acalmá-la, as pessoas notam que o discurso raramente se torna realidade.

Okkay_Dan disse:

Lily Ray, grande especialista, na mesma linha contou:

Quando o Google anunciou essa atualização, ELES foram os que declararam publicamente que a recuperação é possível e que os sites poderiam começar a recuperar o tráfego após fazer mudanças e melhorias que removeriam o classificador que suprimia o tráfego dos sites. Na verdade, há até uma gravação do Google afirmando originalmente que a recuperação seria possível “dentro de algumas semanas”. Claro, essa linguagem mudou gradualmente para “alguns meses” e, eventualmente, para cronogramas ainda mais ambíguos, levando até agora – onde o Google disse em vários Creator Summits – incluindo um há algumas semanas – que “ainda estamos trabalhando nisso e estamos levando a sério; não é uma solução da noite para o dia”. Os proprietários de sites dependiam de cada palavra do Google e esperavam por meses e meses — enquanto investiam em suporte externo e reformulavam seus sites — por qualquer sinal de mudança que os ajudasse a se recuperar. Já se passaram quase 2 anos e muito poucos locais da HCU tiveram alguma recuperação significativa, apesar das mudanças e melhorias drásticas. Este não é o caso de sites afetados por outras atualizações de algoritmo fora do HCU. Trabalhei pessoalmente em dezenas de recuperações ao longo dos anos, e há inúmeros exemplos de sites que conseguiram voltar às boas graças do Google após serem afetados por atualizações ou penalidades.

São parcas e poucas as atualizações que gerem problemas para grandes sites de grandes empresas. Na maior parte das vezes, só acontecem via ação manual (um Googler apertando botões) quando algum caso é grandioso o suficiente para macular a reputação da empresa.

O futuro do contéudo

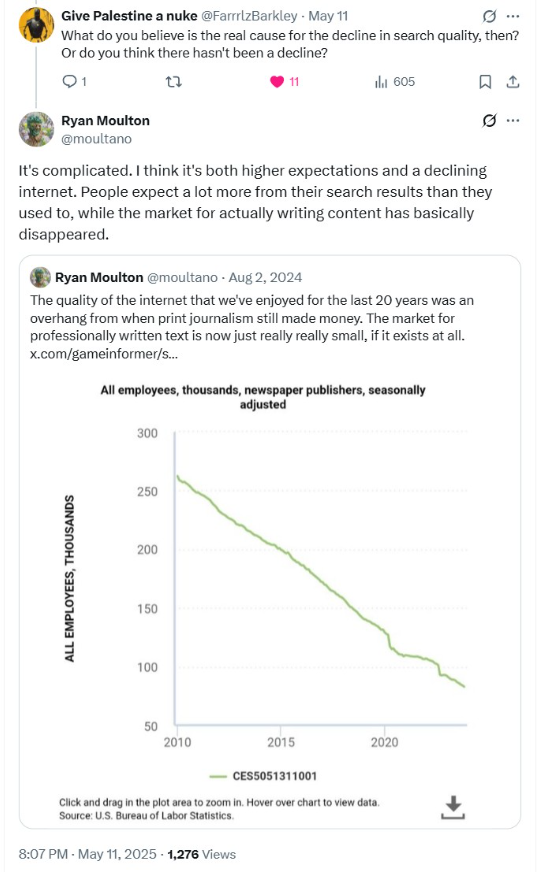

A crise é palpável. Ryan Moulton, um Googler, publicou um gráfico mostrando um declínio de cerca de 70% nos empregos em jornais desde 2010.

Esse número nem sequer considera a consolidação de veículos por fundos de private equity, que os endividam e extraem o máximo de valor, muitas vezes às custas de planos de pensão subfinanciados. A qualidade da internet que desfrutamos por duas décadas foi, em grande parte, um legado do jornalismo impresso rentável. Hoje, o mercado para texto profissionalmente escrito é ínfimo, se é que ainda existe.

Questionado sobre a causa do declínio na qualidade da busca, Moulton (em resposta agora deletada) atribuiu a “expectativas mais altas e uma internet em declínio. As pessoas esperam muito mais de seus resultados de busca, enquanto o mercado para realmente escrever conteúdo basicamente desapareceu.”

No conteúdo linkado acima, até trouxemos uma visão publica do Google News. Mas, qualquer tipo de benefício soa parecido com grandes empresas que destroem uma região, entretanto, fazem uma escola pública como contrapartida.

A tempestade perfeita: de blogs a feeds, de jornais a private equity, e agora… IA

O cenário atual é o resultado de uma série de transformações: blogs substituídos por feeds sociais, jornais engolidos por private equity, grandes portais de “autoridade” fazendo parcerias duvidosas para seções de afiliados, enquanto sites de afiliados independentes são enterrados. É o legado de algoritmos como Vince, Panda, Penguin e o Helpful Content Update – respostas do Google a fenômenos que ele mesmo, em parte, fomentou (como o financiamento inicial do eHow e o sucesso da Demand Media).

E a próxima camada dessa crise é a Inteligência Artificial. Nick Fox, do Google, resumiu a encruzilhada: “Temos 3 opções: (1) A busca não se erode, (2) perdemos tráfego de busca para o Gemini, (3) perdemos tráfego de busca para o ChatGPT. (1) é preferível, mas o pior caso é (3), então devemos apoiar (2).” A mensagem é clara: enquanto o Google sobreviver, todo o resto é secundário.

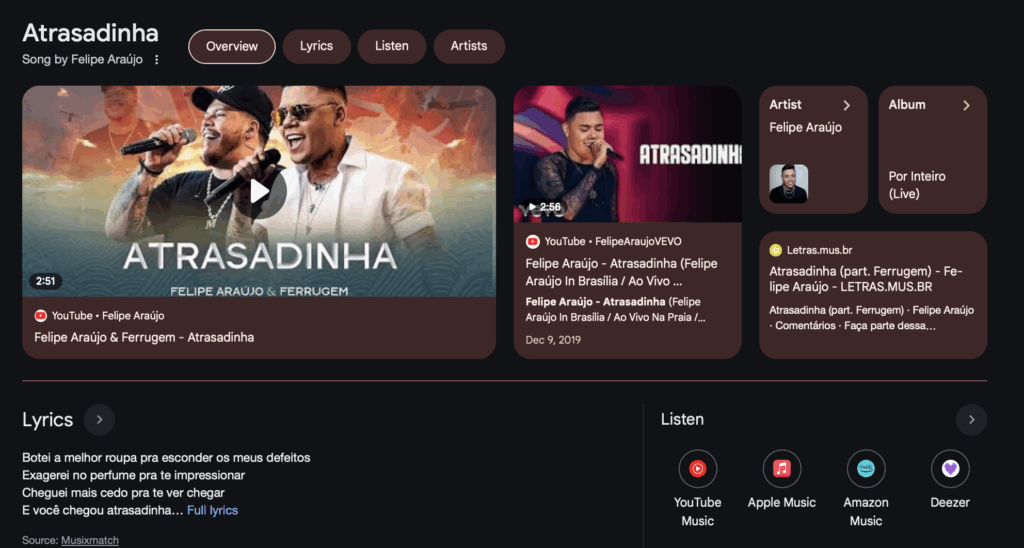

A distribuição de “AI Overviews” (resumos gerados por IA nos resultados de busca) aumentou 116% nos últimos meses. O Google destaca massivamente o Reddit em seus resultados, enquanto fóruns menores sofrem com as atualizações de algoritmo.

O problema da atribuição e confiança na era da IA

Se antes a falta de transparência nos incentivos econômicos já era um risco (lembrando o exemplo do “câncer cerebral”), como ficam os resultados de busca gerados por IA?

- Fontes obscuras: Como esses resultados são construídos? Quão bem citam suas fontes?

- Conteúdo gerado por IA citando IA: As fontes citadas também estão usando IA para gerar seu conteúdo?

Karl Denninger articula a preocupação: “piorou muito porque a ‘IA’ está agora, em muitos ‘mecanismos de busca’, substituindo os primeiros resultados, o que ofusca totalmente de onde sua suposta ‘resposta’ veio… dado que a IA frequentemente ‘alucina’… sem atribuição de como chegou àquela afirmação, você essencialmente destruiu o que era ‘busca’.” Se busco sobre “total return swaps”, a fonte da informação é crucial. Especialistas como Janet Tavakoli existem, mas também existem não especialistas. Qual fonte a IA usou? Quão preciso é o resumo? Não há como saber.

Essa “canibalização” do ecossistema é tão profunda que o Google agora investe em fundos de IA da Arábia Saudita. Enquanto isso, conglomerados de mídia como a IAC (dona de marcas como Expedia, Match.com, e após aquisições, The Spruce, Very Well, People, Better Homes and Gardens) dominam os resultados orgânicos, mas mesmo eles sentem o aperto. A Dotdash Meredith (DDM), parte da IAC, reportou crescimento anêmico e um declínio nas sessões de usuários, em parte devido à queda no tráfego de referência das plataformas de busca, com os AI Overviews do Google começando a “comer” seu tráfego.

O que faz alguém produzir conteúdo hoje?

Quem não começou a produzir conteúdo antes, dificilmente se sente motivado a fazer algo de valor, em texto, pensando em ser encontrado no Google.

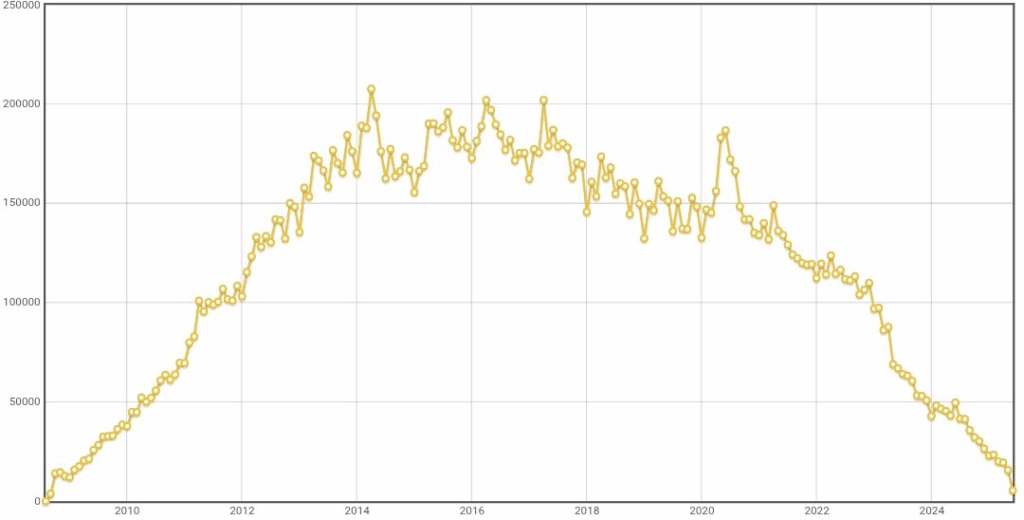

Isso ressoa até mesmo no tráfego gerado por usuários (UGC). Veja a quantidade de perguntas que foram feitas no StackOverflow ao longo do tempo:

De certa forma, o incentivo para que alguém produzia conteúdo hoje é muito pequeno ou nulo.

Conteúdo útil?

O mantra do conteúdo útil, repetido em diversas oportunidades nos últimos anos, sempre foi uma espécie de muleta para o buscador. Por um lado, colocou e coloca até hoje a responsabilidade pela falta de tráfego nos próprios portais. Por outro, evita que as responsabilidades sejam corretamente divididas.

Há casos em que os portais erram? Muitos. Aqui e aqui, mostramos casos disso.

Entretanto, muitos dos que tentam obedecer às diretrizes nem mesmo conseguem ver o resultado do seu trabalho. Nos últimos meses, tive contato com pequenos editores que nem mesmo conseguiram aguentar a produção por muito tempo. Mesmo fazendo uma cobertura exclusiva do tema.

As regras, como são usadas hoje, só servem para beneficiar os infratores.

- Tempo de domínio: tira os concorrentes mais novos (e menores) da jogada, dando uma exclusividade grande para os maiores (que, normalmente, são infratores);

- Quantidade de publicação: por mais que o Google não fale publicamente, sabemos que a quantidade de publicação é um fator positivo; isso faz com que equipes maiores (e, normalmente, as mais infratoras) tenha mais destaque que os blogueiros ocasionais apaixonados, mas altamente especializados no tema tenham algum tráfego.

- Topicalidade: mais uma vez, o Google diz preferir sites que estão dentro de um tópico a um que cobre assuntos gerais. Mas, observe, quantas vezes você verá grandes jornais tendo mais espaço que sites especializados? Muitas vezes. Inclusive, vimos o site Lance! tendo um volume grande de tráfego para falar de banalidades.

No final das contas, o conteúdo de fato útil é desincentivado a todo momento quando no Discover e na pesquisa você apresenta justamente quem faz o inútil.

Nesse sentido, quem é, de fato, apaixonado por conteúdo deixa de produzir, abrindo ainda mais espaço para os que amam tráfego acima de tudo consiga com seu conteúdo inútil.

O histórico de práticas questionáveis e o futuro incerto

O crescimento inicial do Google foi impulsionado por tecnologia superior e marketing inteligente (Toolbar). Depois, vieram pacotes forçados no Android e pagamentos por posições de busca padrão em navegadores de terceiros – uma estratégia tão dominante que, segundo um estudo do Reino Unido, mesmo que a Microsoft desse à Apple 100% da receita do Bing, não conseguiria competir com a oferta do Google pelo Safari.

Ao longo do tempo, o Google criou sinais de ranqueamento que eram, em alguns casos, parasitários ou puramente anticompetitivos. A empresa enfrenta processos bilionários na Europa por sua estratégia no Google Shopping.

A administração Obama, vista por alguns como uma extensão do Google, poupou a empresa de ações mais duras da FTC, apesar de evidências de comportamento anticompetitivo com dano real ao consumidor. O Wall Street Journal revelou que o Google “automaticamente impulsionava o ranqueamento de suas próprias propriedades verticais acima dos concorrentes”, como Google Product Search e Google Local, muitas vezes populando esses serviços com conteúdo de terceiros sem permissão.

Com a IA, a linha do “empréstimo” de conteúdo torna-se ainda mais turva. O Google pode alegar ter obtido conteúdo de um terceiro que, por sua vez, o plagiou ou era apenas um afiliado.

Uma encruzilhada para a qualidade da web

O Google, de motor de descoberta a gigante da monetização, desempenhou um papel central na atual crise do conteúdo de qualidade. Suas decisões, otimizadas para crescimento e lucro, criaram um ambiente onde a informação superficial e otimizada para máquinas muitas vezes supera o conteúdo profundo e bem pesquisado. As práticas anticompetitivas, a priorização de suas próprias propriedades e a recente investida na IA sem a devida transparência nas fontes apenas aprofundam as preocupações.

O futuro da internet de qualidade está em xeque. Sem uma mudança fundamental na forma como o valor é distribuído e como a qualidade é incentivada, a tendência é de um declínio contínuo, onde os usuários perdem o acesso à diversidade de vozes e informações confiáveis, e os criadores de conteúdo lutam para sobreviver em um ecossistema cada vez mais hostil. A pergunta que fica é: a que custo o Google continuará a “comer o bolo inteiro”?

A resposta que temos é que precisamos pensar diferente e depender cada vez menos do buscador para obtenção de tráfego. E, de alguma forma, devemos antagonizar Google e conteúdo útil.

Publisher do "Não é Agência!" e Especialista de SEO, Willian Porto tem mais de 21 anos de experiência em projetos de aquisição orgânica. Especializado em Portais de Notícias, também participou de projetos em e-commerces, como Americanas, Shoptime, Bosch e Trocafone.

- Willian Portohttps://naoeagencia.com.br/author/naoeagencia/

- Willian Portohttps://naoeagencia.com.br/author/naoeagencia/

- Willian Portohttps://naoeagencia.com.br/author/naoeagencia/

- Willian Portohttps://naoeagencia.com.br/author/naoeagencia/